1. 개요 및 연구동기

CNN과 LSTM 네트워크를 이용하여 영상데이터에서의 action recognition 방법을 제안한다.

1. 비디오의 6번째 프레임마다 깊은 특징이 추출된다.

2. DB-LSTM 네트워크를 사용하여 프레임 특징들 사이의 순차적인 정보를 학습한다.

본 논문에서는 LSTM 을 사용하여 이전 프레임의 정보를 고려하게 한다.

제안하는 방법은 LSTM을 사용하여 프레임 간 변화를 분석한다. RNN은 시간 t에서 활성화되어 테이터를 순서대로 선택적으로 처리할 수 있다.

3. Proposed Framework

CNN은 이미지 표현 및 분류를 위한 지배적인 방법이다. 영상 데이터의 경우 각각의 프레임을 CNN feature 로 표현한 뒤 DB-LSTM 을 사용하여 프레임 간의 순차적인 정보를 표현한다. 단위 시간에 30~50 프레임이 지나가면 그 안에는 중복 프레임이 많아서 본 연구에서는 6프레임 당 1프레임만 사용한다. feature representation 의 시나리오는 그림 2에 나와있다. CNN은 프레임의 작은 변화를 탐지하고 형태의 변화는 RNN을 통해 학습된다.

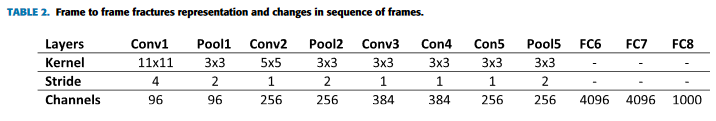

CNN을 훈련시키기 위한 방대한 데이터셋이 필요하다는 점을 Transfer learning으로 해결했다. CNN 모델 구조는 표 2 에 나와있다.

Recurrent Neural Networks

RNN 은 시간 순치 및 공간 순차 데이터 모두에서 숨겨진 순차 패턴을 분석하기 위해 도입되었다.

여기서는 LSTM을 사용하며 식 1~7은 LSTM의 작업을 설명한다.

본 연구에서는 LSTM을 2개층으로 쌓아서 사용했으며 그 그림은 그림 3과 같다.

레이어의 state를 계산하는 식을 8로 일반화한다.

실험결과

참고자료

https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=8121994

IEEE Xplore Full-Text PDF:

ieeexplore.ieee.org

Part N. Action (Video) Classification / UCF101

## Please see [GitHub Repository](https://github.com/RichardMinsooGo/5_TF2_UCF101_video_classificat…

wikidocs.net

댓글